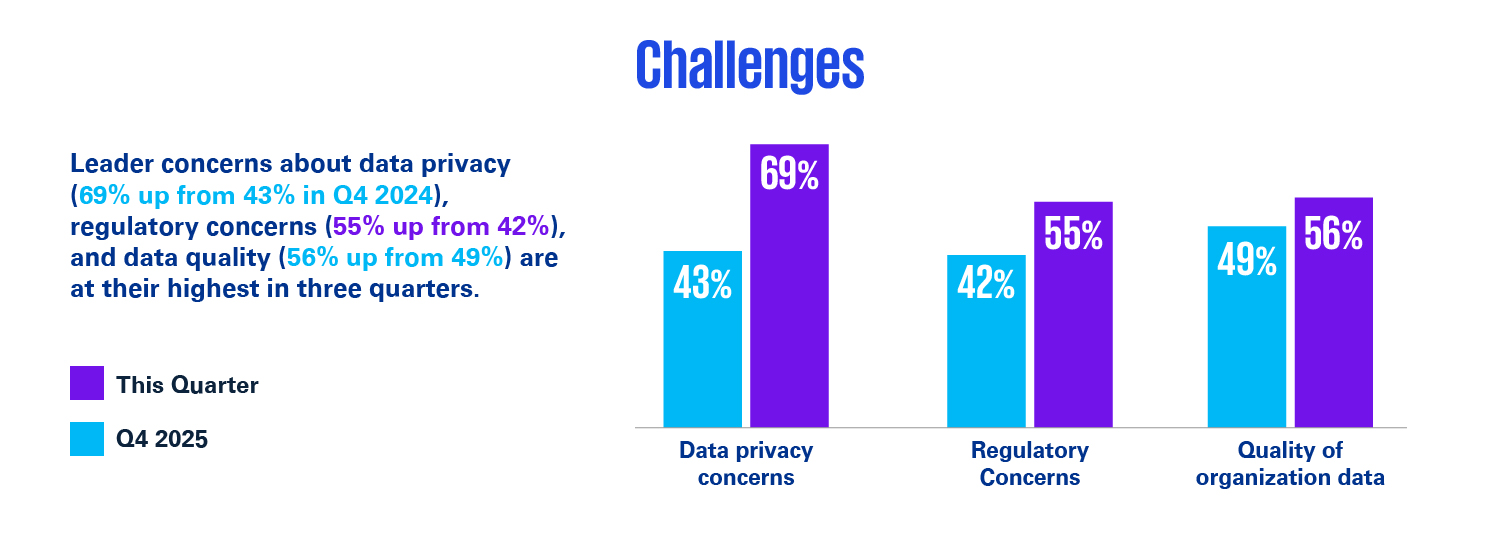

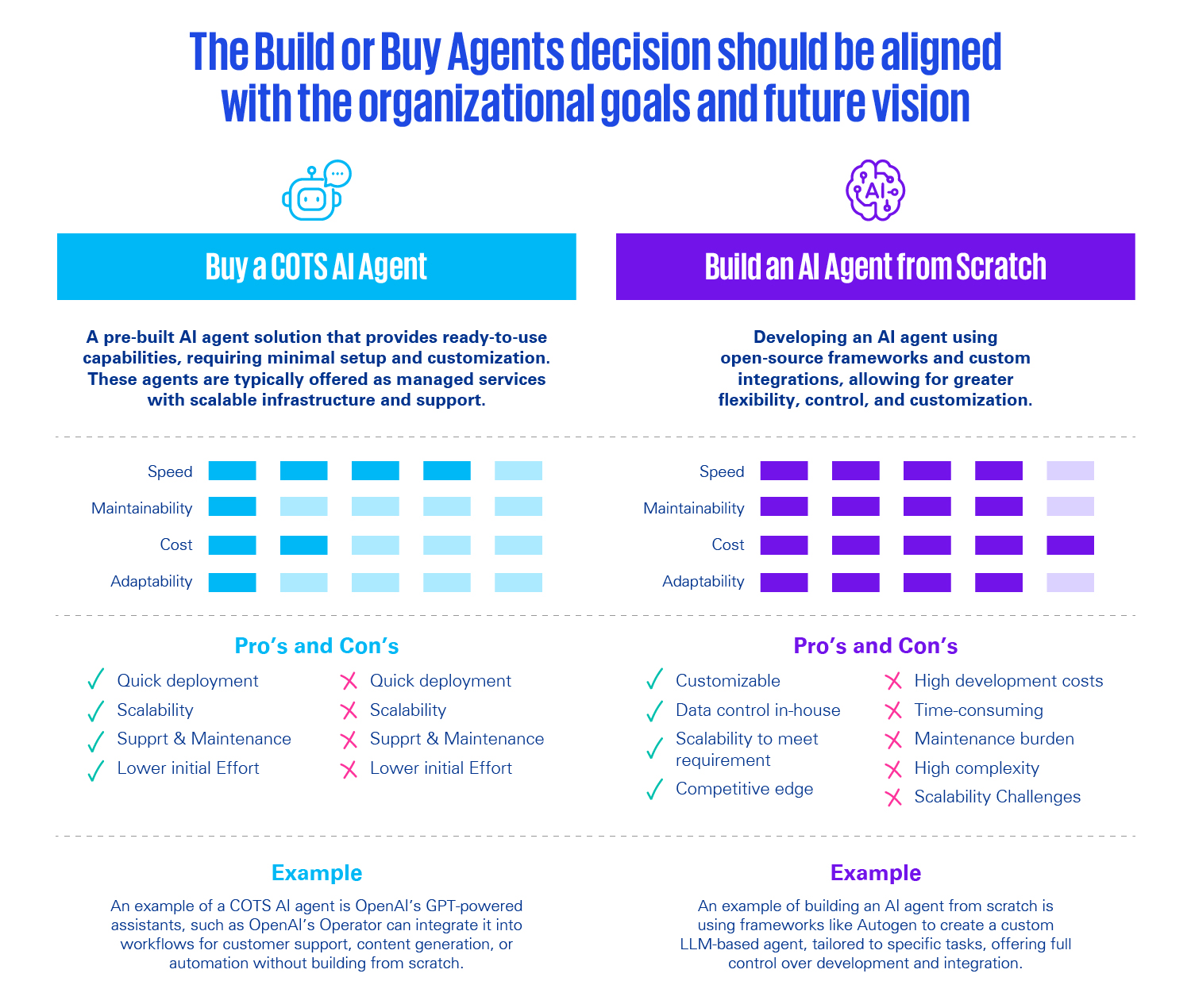

Pueden trabajar 24horas al día, 7 días a la semana de manera independiente, pueden tomar decisiones complejas y se adaptan en tiempo real a los cambios del entorno, se definen como las nuevas plantillas digitales. Eso sí, nada de esto lo pueden hacer sin supervisión humana. Son los agentes de IA y no son ninguna promesa. De hecho, según datos del sondeo trimestral de KPMG sobre la adopción de la IA, correspondiente al segundo trimestre del año, la mayoría de las organizaciones (90 %) ya han superado la fase de experimentación. Y, de ellas, un 33 % ha logrado implementar, al menos, algunos agentes.

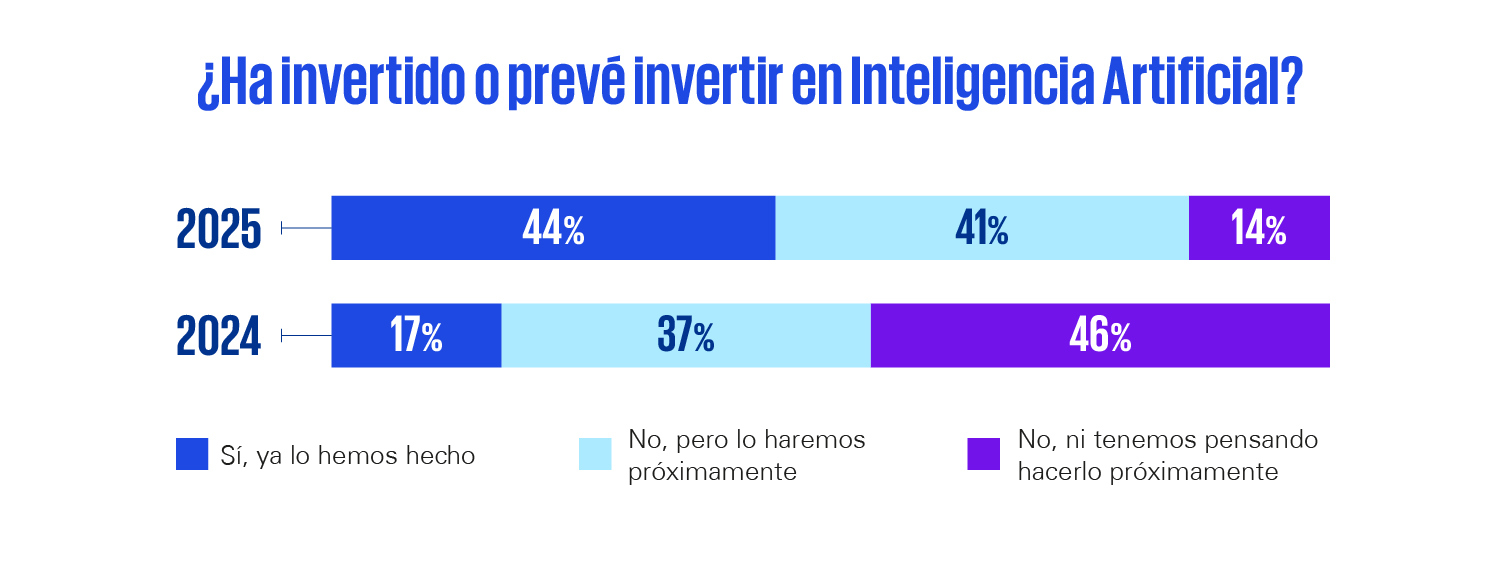

Y es que el tejido productivo mundial parece haberse puesto de acuerdo en algo: la transformación tecnológica, y más concretamente la carrera por la IA, es una carrera de fondo en la que nadie quiere quedarse el último. Y año a año, sigue ganando adeptos. Lo muestra el informe ‘Perspectivas España 2025: IA y Transformación’: mientras que en 2024 los empresarios españoles que ya habían invertido en IA eran el 17%, este porcentaje aumentó hasta el 44% en 2025.